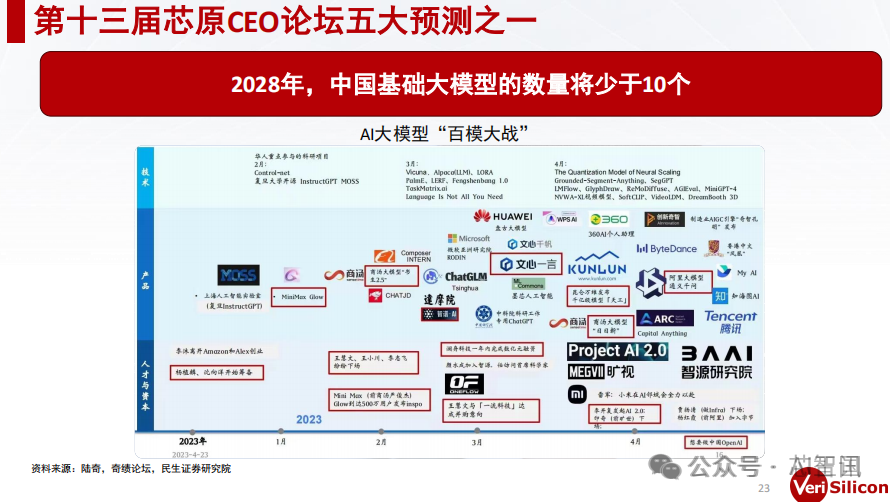

7月7日,在中国RISC-V产业联盟理事长、芯原微电子创始人戴伟民博士看来,当前AI领域的“百模大战”现象更像是一种资源的浪费。他指出,自ChatGPT引发生成式AI热潮以来,众多企业纷纷投入大模型研发,但这种“群模乱舞”的现象实际上并不经济。要实现超越人脑智能的AI,需要不断扩大模型参数规模,这对计算力的需求呈指数级增长,将导致巨大的电力消耗。他预测,到2028年,中国基础大模型的数量将少于10个,更理想的状态是5个。

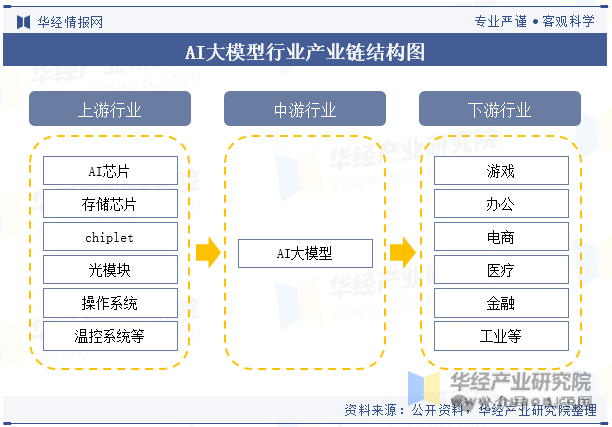

近年来,大模型引发社会各界广泛关注,包括芯片、资本、云计算、内容服务商纷纷置身其中,新一代人工智能再掀热潮。以下将详细介绍一些中国大模型的具体规模和发展现状:

百度的文心一言大模型:这是一个预训练模型,具备多任务通用求解能力,参数规模达到数十亿。

阿里巴巴的通义千问大模型:同样拥有数十亿参数,主要用于提升自然语言处理的性能。

云知声的山海大模型:以视觉任务为主,参数规模也达到了数十亿,特别是在医疗问诊方面有应用。

DingoDB多模向量数据库:这种类型的大模型能处理多种模态的数据,如图像、文本、语音等,参数规模根据具体应用场景不同而有所差异。

用友的YonGPT大模型:专为特定行业设计,用于提升业务流程效率和准确性。

蔚来的NOMI GPT大模型:用于车载系统中,提升了驾驶体验和人机交互能力。

硬件资源紧张:随着模型规模的扩大,对高性能计算资源的需求也水涨船高,这导致了GPU、TPU等高性能计算设备的供应紧张,影响了其他领域研究和企业需求。

过度追求规模:在AI领域内,存在一种“越大越好”的错误认知,导致研究者和公司为了追求规模上的领先而忽视了实际应用中的效果与成本平衡。

在资源有限的情况下,如何更有效地利用资源,提高研发效率,将是AI领域面临的重要问题。同时,这也提醒我们在追求技术进步的同时,不能忽视环保和可持续发展的重要性。