英伟达首席执行官黄仁勋在今年早些时候展示了下一代Blackwell芯片。

英伟达首席执行官黄仁勋在今年早些时候展示了下一代Blackwell芯片。

01 技术突破与挑战并存:英伟达的AI芯片战略

英伟达的未来,正豪赌在那些推动技术边界的芯片上。随着公司不断拓展芯片制造的极限,制造过程中的障碍也导致了延误和成本的增加。正如Asa Fitch所报道,英伟达CEO黄仁勋展示了公司在AI芯片领域的雄心壮志——以“越大越好”的理念,推动业务的爆炸性增长。然而,这种规模的扩大也带来了更多的挑战。

02 市场动态:AI芯片行业增长与英伟达的股价波动

英伟达最新的人工智能芯片,被称为Blackwell,其尺寸大约是四个拼字游戏棋子排列成的正方形那么大,是去年推动公司业务激增的芯片的两倍。这些新芯片的性能大幅提升,晶体管数量是之前的2.6倍,黄仁勋表示市场需求非常旺盛。但是,英伟达在公布强劲的销售和利润的同时,也透露了制造这些新芯片的挑战是导致利润率下降和最近期间9.08亿美元准备金增加的主要原因。这些因素导致其股价在第二天下跌了6.4%。

03 制造工艺的难题:Blackwell芯片的设计与产量挑战

制造每一个芯片都需要接近完美的工艺:任何一部分的严重缺陷都可能导致整个芯片的失败,并且随着涉及的组件数量增加,发生这种情况的可能性也在增加。此外,所有这些组件产生的热量有可能以不同的速率使封装中的不同材料变形,给制造带来了更多的复杂性。

在台湾半导体制造公司创新博物馆展出的英伟达芯片。

英伟达的Blackwell芯片设计变更旨在提高产量,但并没有对芯片进行“功能性改变”。首席财务官Colette Kress表示,公司正按计划增加Blackwell的生产,并预计它将在截至1月的季度为收入贡献数十亿美元。瑞银的分析师在本月早些时候的报告中指出,Blackwell的主要问题在于使用台积电提供的一种新的芯片连接方式的复杂性,这是英伟达芯片生产的主要障碍,尽管随着产量的提高,预计明年将能够按计划生产芯片。

英伟达最近转向每年发布新一代芯片,而不是之前的每两年一次,这增加了迅速解决制造问题的压力。公司在周三的证券备案中承认了这种动态,称“新引入产品的频率和复杂性的增加可能导致质量或生产问题”,这可能导致成本上升或造成延误。

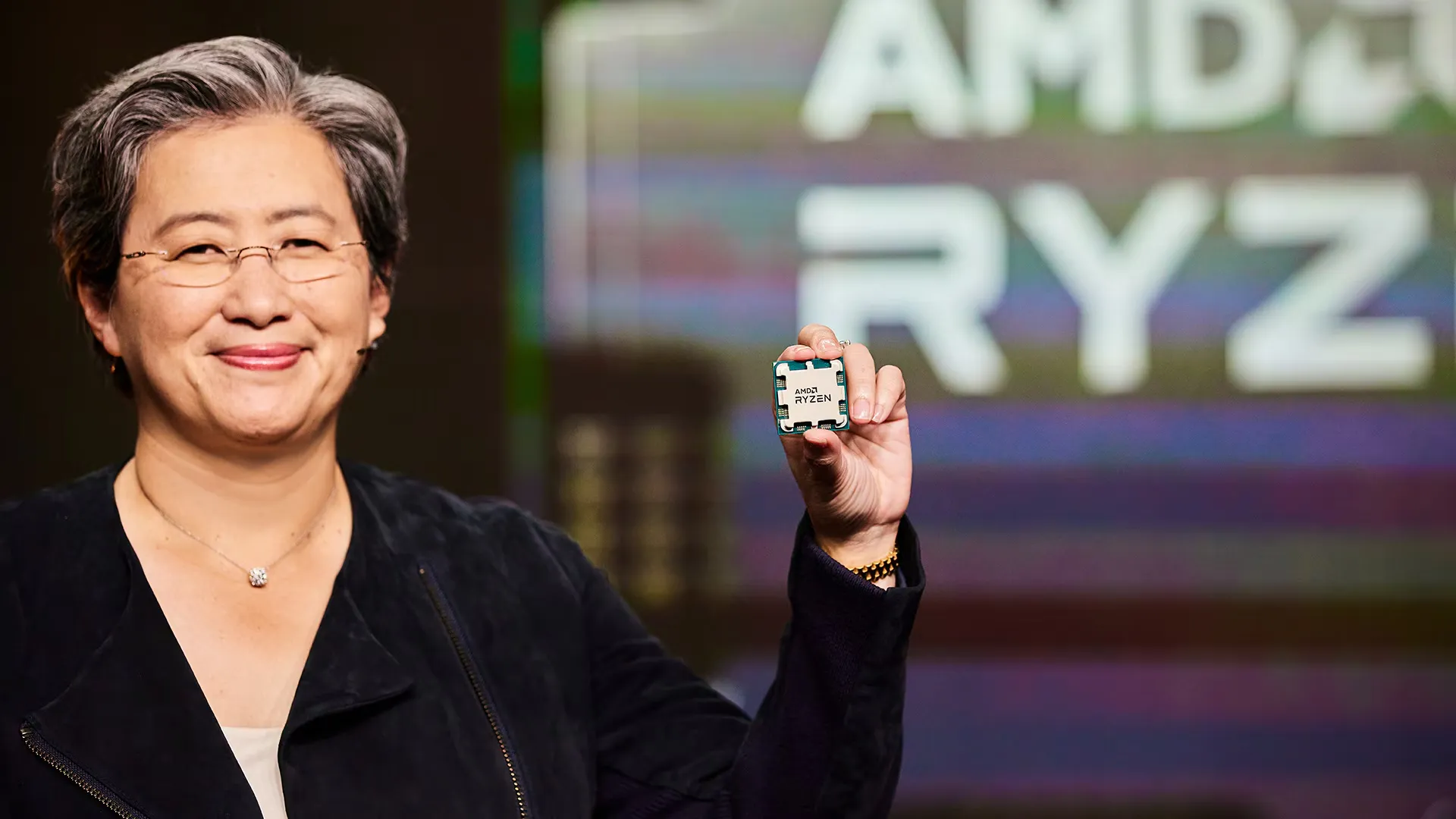

尽管如此,英伟达的竞争对手,如Advanced Micro Devices的首席执行官Lisa Su认为,随着公司寻求通过堆叠芯片和使用更多硅来提高性能,未来的复杂性将会增加。她还指出,下一代芯片的好处在于它们更加节能,需要的电力更少,这是一个日益增长的担忧,因为AI数据中心正在消耗大量的电网容量。

AMD首席执行官Lisa Su。

黄仁勋将Blackwell的规模作为卖点,他在3月的英伟达会议上表示:“它只是一个巨大的芯片。”“当我们被告知Blackwell的雄心超出了物理极限时,工程师们说,‘那又怎样?’”。

05 行业展望:AI芯片市场的扩张与预测

在AI芯片行业中,英伟达以其GPU主导了AI计算市场,1999年首次提出可从真正意义上替代CPU渲染的GPU概念,之后持续深耕于GPU产品。2006年之后,为解决GPU编程复杂度问题,英伟达推出了通用并行计算平台CUDA,大幅降低了用GPU进行通用计算的难度,为AI算力的支撑打下了基础。

全球AI芯片市场规模预计将在未来几年持续扩大,从2022年的约441.7亿美元增长到2024年的671亿美元,年均复合增长率达到15.0%。在区域分布上,欧美地区一直是AI芯片市场的重要区域,占据42.6%的市场份额,而亚太地区也表现不俗,占比达到16.2%。中国市场规模自2018年的64亿元增长至2021年的850亿元,年均复合增长率高达67.7%,并预计在2024年将达到2302亿元。

在中国AI芯片行业中,英伟达GPU在中国AI加速卡市场占据85%的市场份额,华为和百度分别占据10%和2%。中国AI芯片行业投融资热度较高,2023年投资事件达84起,融资金额约200.69亿元。2024年1-2月,投资事件共13起,融资金额约25.63亿元。代表性企业包括华为海思、寒武纪和地平线等,其中华为海思的昇腾310 AI处理器在典型配置下可以输出16TOPS@INT8,8TOPS@FP16,功耗仅为8W。

04 竞争加剧与应对策略:新兴企业Cerebras Systems的崛起

与此同时,Open AI投资的AI芯片制造公司Cerebras Systems直接对标英伟达,开发了有史以来最大的芯片,这些芯片通常是被切成小块的硅片,但Cerebras找到了如何连接和操作它们作为一个巨大的芯片的方式。Cerebras最近推出了一项云计算服务,用于AI部署,挑战了英伟达的主导地位,并已经吸引了包括阿斯利康和梅奥诊所在内的客户。Cerebras最近还秘密向美国提交了首次公开募股申请。

Cerebras Systems于2024年8月28日宣布推出Cerebras Inference,这是一款全球最快的AI推理解决方案。该方案在Llama 3.1 8B模型上实现了每秒1800个token的处理速度,在Llama 3.1 70B模型上达到每秒450个token,速度是微软Azure等超大规模云服务中基于英伟达GPU的AI推理解决方案的20倍。同时,Cerebras Inference的定价远低于主流GPU云服务,起价仅为每百万个token 10美分,性价比提升高达100倍。Cerebras Inference使用了Cerebras CS-3系统及其Wafer Scale Engine 3(WSE-3)AI处理器,其中CS-3的内存带宽是Nvidia H100的7000倍,解决了生成式AI的内存带宽技术挑战。

迄今最快的芯片将为大型AI超级计算机提供动力。图片来源:Cerebras Systems官网

为应对AI带来的爆炸性需求以及竞争对手的挑战公司也在探索新的芯片架构,如Grace Hopper超级芯片,以应对高性能计算和AI工作负载的需求。英伟达将产品更新速度从两年一次提升到一年一次,同时推出Grace Hopper超级芯片架构等方式进行应对。

Grace Hopper是高性能计算(HPC)和AI工作负载的第一个真正的异构加速平台。它结合了GPU和CPU的优势来加速应用程序,同时提供了简单高效的分布式异构编程模型。NVIDIA Grace Hopper超级芯片通过NVIDIA NVLink-C2C技术,将NVIDIA Grace CPU和Hopper GPU融合到一个超级芯片中,提供高达900 GB/s的总带宽,比传统PCIe Gen5通道高7倍。

英伟达在2022年3月22日的GTC大会上宣布推出了基于Arm Neoverse的数据中心专属CPU——NVIDIA Grace CPU超级芯片,专为AI基础设施和高性能计算设计。这款超级芯片由两个CPU芯片组成,通过NVLink®-C2C互连技术连接在一起,提供高带宽、低延迟的芯片到芯片互连。Grace CPU超级芯片在SPECrate®2017_int_base基准测试中的模拟性能达到业界领先的740分,是当前DGX A100搭载的双CPU的1.5倍以上。它还提供业界领先的能效和内存带宽,LPDDR5x内存子系统提供每秒1TB的带宽,同时功耗仅为500瓦。

结语:

随着人工智能技术的不断进步和市场需求的日益增长,英伟达正站在这场技术革命的前沿。尽管面临制造过程中的挑战和成本上升,公司依然展现出了强大的创新能力和市场领导地位。Blackwell芯片的推出,不仅是对技术极限的一次豪赌,更是对未来AI芯片市场的一次深远布局。

然而,正如任何行业的领导者所必须面对的,随着规模的扩大,英伟达也必须应对更为复杂的生产问题和激烈的市场竞争。Cerebras Systems等新兴企业的崛起,以及像华为、百度这样的本土竞争对手的快速发展,都在推动着整个行业向着更高的技术标准和更广阔的应用场景迈进。

在这个快速变化的时代,英伟达需要不断优化其产品线,提高生产效率,并在保持技术领先优势的同时,探索新的商业模式和市场策略。同时,随着全球AI芯片市场的持续扩大,英伟达也有机会进一步巩固其在全球市场中的领导地位。

最终,英伟达的未来将取决于其如何应对这些挑战,以及如何利用其技术优势来满足不断变化的市场需求。正如黄仁勋所展示的雄心壮志,英伟达将继续推动技术边界,引领AI芯片行业走向更加辉煌的未来。