苹果或许给了AI新的概念,Apple Intelligence而不是Artificial intelligence。苹果在WWDC 2024上提出了全面集成APPLE多个产品的个人智能系统,与目前卷的如火如荼的各大厂商不同,苹果追求小模型,而不是大力🧱飞。

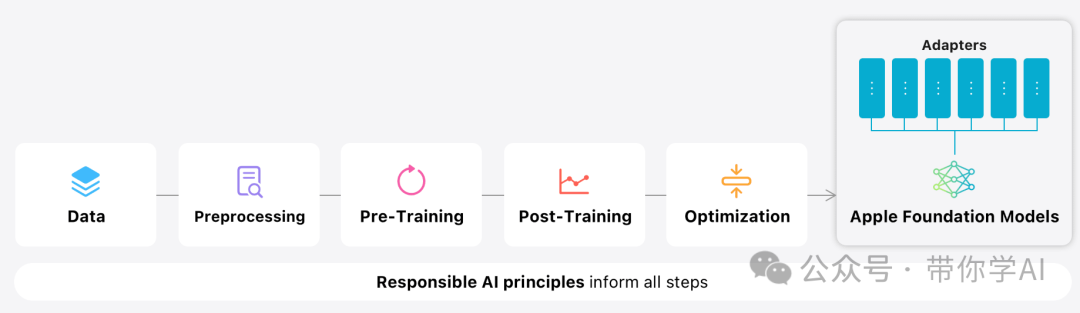

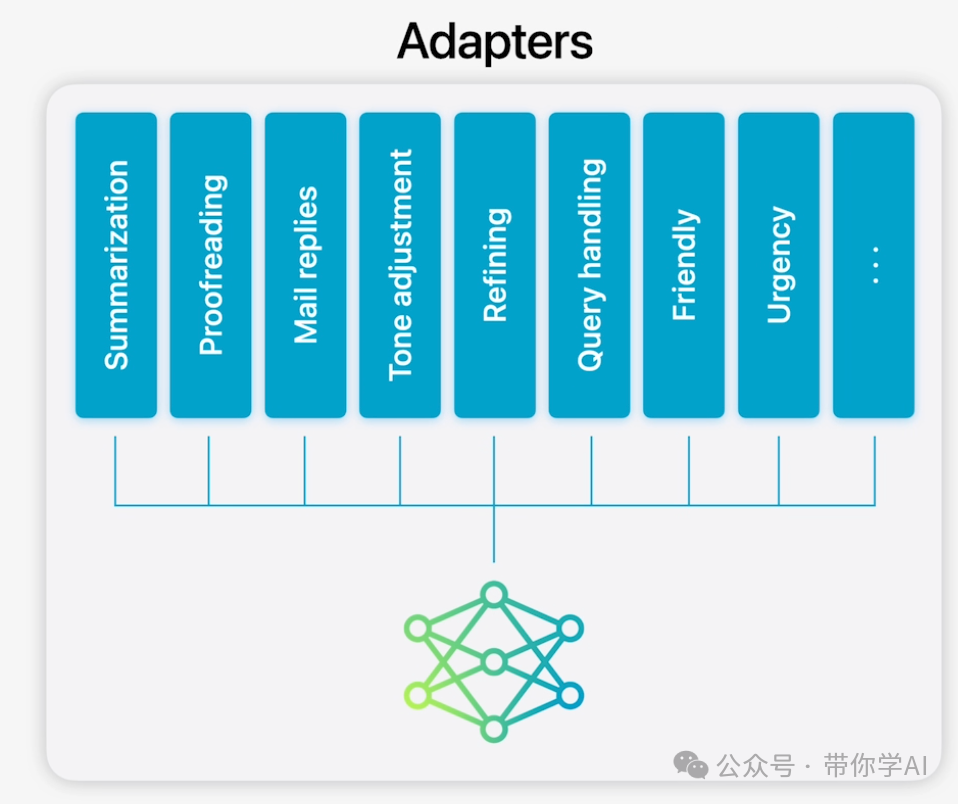

苹果提出优先考虑用户体验,更强调AI模型的定制化,利用多种小模型进行组合,专门用于用户的日常任务,可以即时适应用户当前的活动。Apple Intelligence 内置的基础模型已针对用户体验进行了微调,例如编写和优化文本、确定通知的优先级和摘要、为与家人和朋友的对话创建有趣的图像,以及采取应用内操作以简化跨应用交互。

大模型意味着在智能手机中整合更大、更复杂的神经网络模型,以提升AI的能力。然而,这类模型也面临一些挑战和限制。大模型需要更多的计算资源和存储空间,这对手机的硬件性能和电池续航提出了更高的要求。大模型的训练和优化需要海量的数据和长时间的处理,这对厂商来说是一项巨大的工程。小模型具有体积小、计算资源需求低、训练效率高等特点,适合在智能手机上运行。

当然你会想,直接调用接口不就可以了,但这会存在很明显的数据问题,对于终端服务厂商尤其是跨国企业这是非常负责的问题。苹果在2024年全球开发者大会发布了两个模型,一个约 30 亿参数的设备语言模型,以及一个更大的基于服务器的语言模型。

其实苹果对AI持有的态度很谨慎,大家几乎很少听到苹果自己的AI模型的新闻,但其实它更关注的是隐私和合规,以及人工智能的响应速度和可靠性。相比其他科技公司,苹果并不追求大模型性能的绝对领先,而是更看重大模型落地的可能性。

目前,大多数大型模型都是在云端运行,尽管它们拥有更大的参数规模和更高的算力,但也有显著的缺点。当用户处于弱网或离线环境时,无法使用这些大型模型的功能,甚至可能面临用户隐私安全泄露的风险。这对于极其注重用户体验的苹果公司来说,是难以接受的。

为了让大型模型能够在设备端运行,除了需要提升内存容量之外,对模型进行压缩和优化也是可行的方法。压缩模型意味着缩小模型的规模,使其在关键场景中保持高精度和效果;优化模型则是通过技术手段改进模型,减少内存搬运以降低功耗。

目前,大多数科技公司将更多精力投入到训练参数更少、体积更小的“小模型”上。然而,苹果选择了另一条道路。此前,苹果发布的一篇论文显示,它尝试利用闪存来解决大模型在手机上运行时遇到的内存不足问题。简而言之,苹果通过优化闪存交互和内存管理,解决了这一难题。

总结,苹果的2024WWDC重点突出实用和安全。

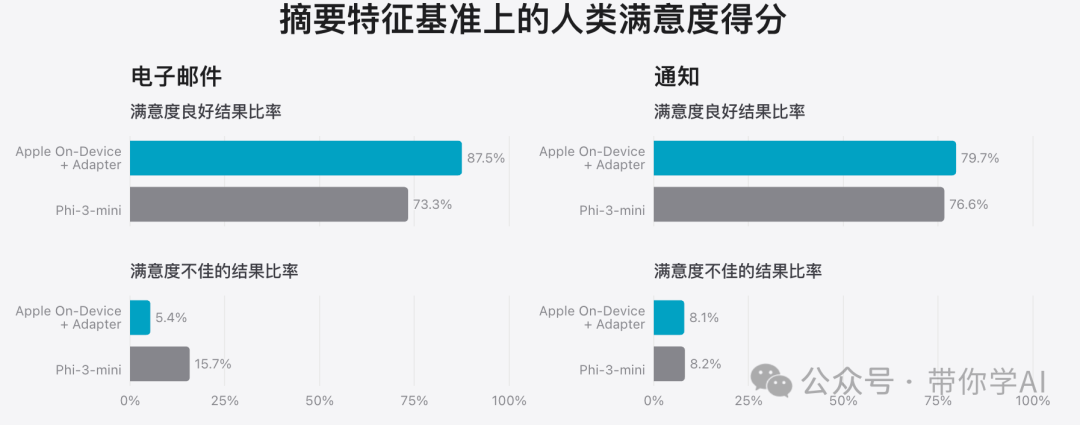

对电子邮件摘要的测试:

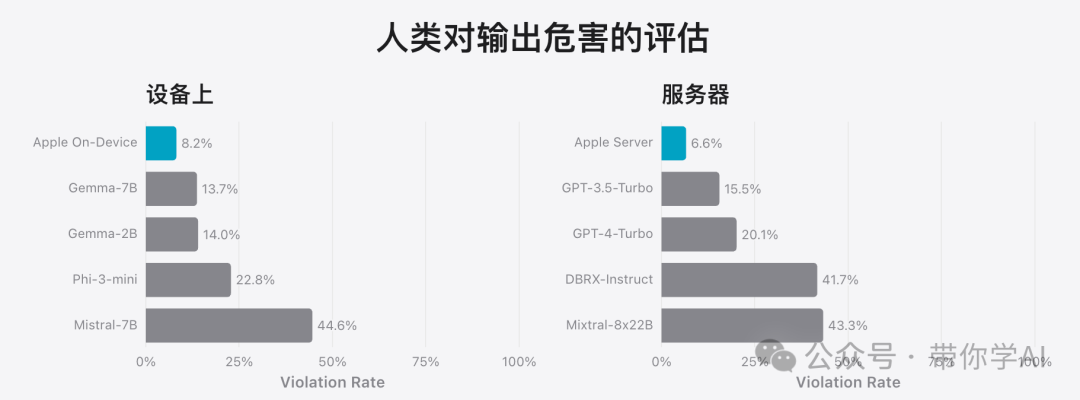

有害内容、敏感主题和事实性方面的表现:

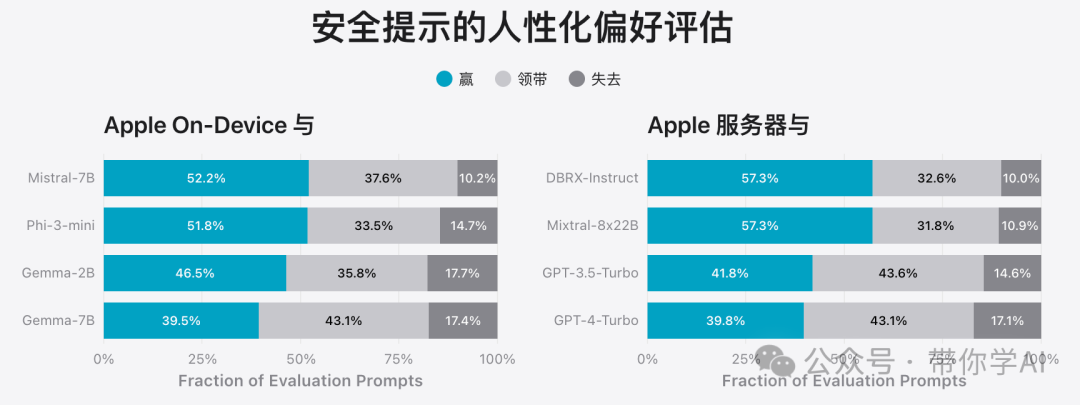

人性化提示的安全性:

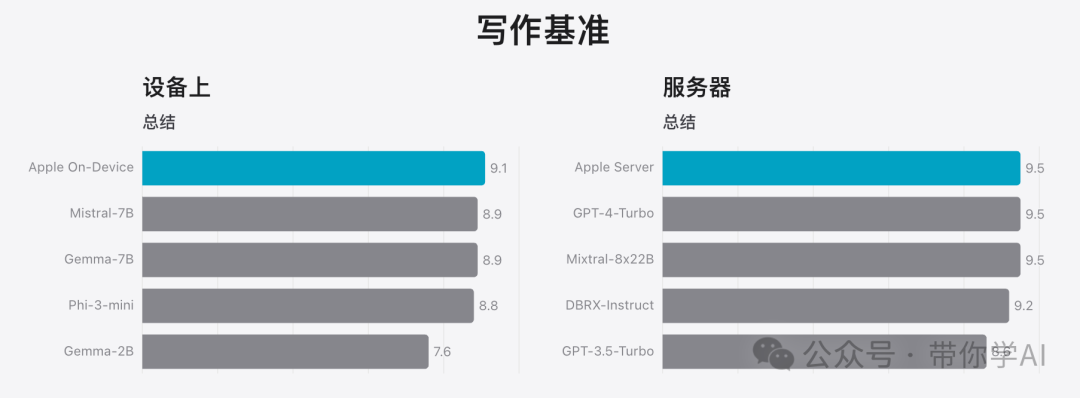

模型的实用性,写作能力:

苹果热衷追求小模型是为了优化设备性能和电池寿命,提升响应速度和用户体验,同时保护用户隐私,通过本地处理减少数据传输需求,并充分利用其硬件优势,实现硬件与软件的协同优化。